La inteligencia artificial generativa (GenAI) ha pasado rápidamente de ser un concepto futurista a una capacidad empresarial esencial. Desde la mejora del análisis con información contextual hasta la creación de chatbots, sistemas de generación aumentada por recuperación (RAG) e incluso agentes totalmente autónomos, la GenAI está transformando la forma en que las organizaciones interactúan con los datos y toman decisiones.

Este último artículo de nuestra serie Databricks & KNIME explora cómo las dos plataformas ayudan a integrar GenAI en los flujos de trabajo, haciendo que las capacidades avanzadas de IA sean accesibles no solo para los científicos de datos, sino también para los analistas de negocios y los expertos del sector.

De BI a GenAI: el camino recorrido hasta ahora

Este blog forma parte de una serie de cuatro entradas que muestran cómo KNIME y Databricks se integran en el ciclo de vida de los datos y la IA:

- Inteligencia empresarial. Cómo KNIME se conecta a Databricks a través de conectores seguros, lo que permite a los analistas consultar las tablas de Databricks, explorar Unity Catalog y mantener todo el procesamiento de datos dentro de Databricks.

- Ingeniería de datos. Cómo la escalabilidad de Databricks y los flujos de trabajo de bajo código de KNIME simplifican la preparación y la transformación de datos a gran escala, eliminando los silos y optimizando los procesos.

- Aprendizaje automático. Cómo KNIME y Databricks se integran para crear flujos de trabajo de aprendizaje automático, desde la ingeniería de características hasta el entrenamiento y la implementación de modelos, cerrando la brecha entre los equipos técnicos de aprendizaje automático y los usuarios empresariales.

Ahora, en esta parte final, partimos de estas bases para explorar cómo la IA generativa puede introducir LLM, chatbots, canalizaciones RAG y agentes en el análisis empresarial.

¿Por qué Databricks + KNIME para GenAI?

Básicamente, Databricks y KNIME se complementan entre sí:

- Databricks proporciona modelos de IA de nivel empresarial, escalabilidad y gobernanza.

- KNIME proporciona la interfaz sin código/con poco código para diseñar, probar e implementar flujos de trabajo que conectan estos modelos con el mundo real.

Esta integración garantiza que los LLM (modelos de lenguaje grandes) y otros modelos GenAI sean accesibles de forma controlada, transparente y colaborativa. Los analistas y los equipos empresariales pueden crear prototipos visuales de las aplicaciones en KNIME, mientras que los equipos técnicos gestionan el modelo y el rendimiento de forma centralizada con Databricks.

La extensión KNIME AI: su puerta de acceso a GenAI

Con la extensión KNIME AI, puedes:

- Conectarte a los LLM y a los modelos de incrustación proporcionados en Databricks.

- Utilizar nodos Prompter independientes del proveedor para enviar instrucciones y solicitudes a los LLM.

- Construir canalizaciones RAG con bases de datos vectoriales como FAISS o Chroma.

- Desarrollar aplicaciones de IA agentica que orquestan flujos de trabajo como «herramientas» dinámicas.

Todo esto se lleva a cabo dentro del entorno KNIME, lo que significa que no es necesario escribir código para crear soluciones que normalmente requerirían un esfuerzo de desarrollo especializado.

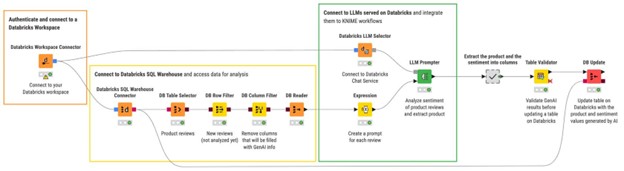

Un flujo de trabajo típico con LLM en KNIME sigue un patrón de este tipo:

- Autentificarse con el proveedor o con el espacio de trabajo de Databricks (por ejemplo, con el conector Databricks Workspace Connector).

Selecciona el modelo deseado utilizando el nodo LLM Selector (por ejemplo, Databricks LLM Selector).

Envía indicaciones a través de un nodo Prompter para interactuar con el modelo.

Casos de uso prácticos

Veamos algunos ejemplos prácticos en los que KNIME y Databricks dan vida a GenAI.

1. Mejora del análisis con GenAI

Una de las aplicaciones más sencillas, pero también más potentes, es la mejora de los flujos de trabajo analíticos con indicaciones dinámicas. Las indicaciones dinámicas pueden definirse como el envío de una instrucción personalizada a un LLM para cada fila del conjunto de datos.

Por ejemplo, supongamos que queremos analizar miles de reseñas de productos almacenadas en Databricks para identificar qué productos se mencionan y el sentimiento de cada reseña (positivo, neutro o negativo).

Con KNIME y Databricks, esto resulta muy sencillo:

1. Conéctate al espacio de trabajo de Databricks.

2. Recupera las reseñas de productos de un almacén SQL. (En este caso, puedes filtrar solo las reseñas nuevas para las que aún no se han extraído el producto y el sentimiento, a fin de evitar duplicaciones en la tabla Databricks de destino).

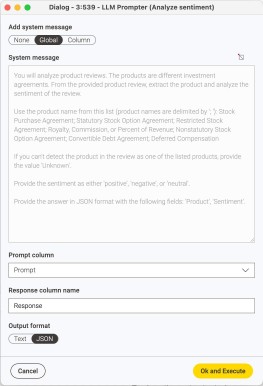

3. Utiliza el prompt dinámico para pedir a un LLM (servido en Databricks) que extraiga tanto el producto como el sentimiento. Utiliza el nodo Expression para crear prompts línea por línea y configura el parámetro «System Message» para proporcionar al LLM las instrucciones pertinentes.

4. Vuelva a escribir el conjunto de datos, ahora enriquecido con la nueva información generada por la IA, en Databricks para funciones posteriores, como informes y modelos de aprendizaje automático.

Esta combinación muestra cómo la IA generativa se puede integrar directamente en los flujos de análisis de datos existentes, sin necesidad de escribir código personalizado.

2. Creación de un chatbot personalizado

Otro caso de uso popular es la creación de un chatbot empresarial basado en LLM alojado en Databricks. De hecho, con solo el nodo Agent Chat View, es posible crear un chatbot en KNIME y conectarlo a un modelo seleccionado mediante el selector LLM de Databricks.

Una vez configurado, el chatbot puede gestionar conversaciones y también se puede distribuir como una aplicación de datos, poniéndolo a disposición de los equipos empresariales.

Los pasos clave incluyen:

- La definición de un mensaje del sistema para establecer la función, el tono, los límites y las reglas de comportamiento del chatbot (este mensaje tiene prioridad sobre la entrada del usuario).

- Añadir un mensaje inicial de IA para guiar el comportamiento inicial del chatbot.

El resultado es un asistente interactivo y personalizado para su empresa.

3. Pipeline RAG

Aunque los LLM son potentes, a veces producen respuestas convincentes pero erróneas. La generación aumentada por recuperación (RAG) resuelve este problema enriqueciendo las indicaciones con información de dominio recuperada de bases de datos vectoriales.

Databricks proporciona tanto LLM como modelos de incrustación, mientras que KNIME ofrece los nodos para conectarse a los modelos, crear bases de datos vectoriales y recuperar la información contextual de estas últimas.

Por ejemplo, imagina que el flujo de trabajo anterior de análisis de reseñas de productos adolecía de alucinaciones debido a nombres de productos especializados o terminología específica del dominio. Para mejorar la precisión, podría construir una canalización RAG:

1. Importa documentos específicos del dominio (por ejemplo, manuales técnicos o informes financieros).

2. Conviértelos en incrustaciones utilizando un modelo de incrustación proporcionado por Databricks a través del selector de modelos de incrustación de Databricks.

3. Almacena las incrustaciones en una base de datos vectorial como FAISS o Chroma utilizando un nodo Vector Store Creator.

4. En el momento de la consulta, recupera la información contextual con el nodo Vector Store Retriever e insértala en el prompt antes de enviarla al LLM.

Este flujo de trabajo proporciona al LLM el contexto correcto, lo que ayuda a reducir las alucinaciones y a mejorar la fiabilidad.

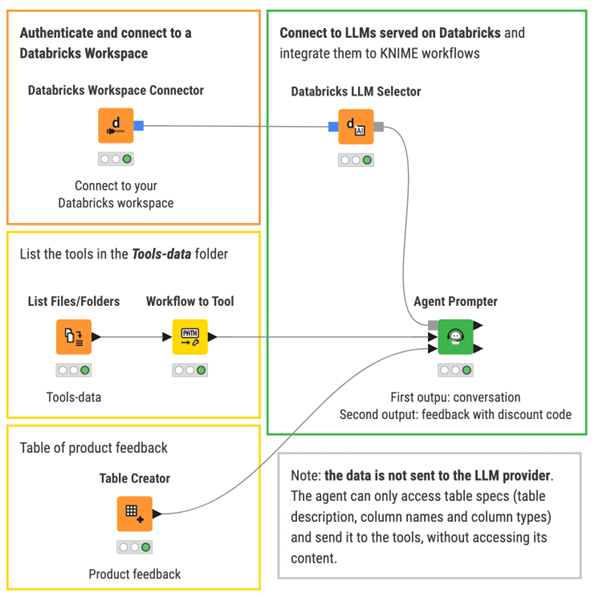

4. Agentes para la automatización adaptativa

Además de los flujos de trabajo individuales, KNIME permite la creación de sistemas agenticos. Se trata de aplicaciones GenAI autónomas capaces de decidir en tiempo real qué herramienta o flujo de trabajo utilizar, en función de la solicitud del usuario.

Los agentes en KNIME se construyen combinando:

- Un nodo Agent Prompter (para interactuar con el LLM).

- Una o más herramientas/flujos de trabajo (flujos de trabajo KNIME transformados en componentes reutilizables).

- Una lógica de decisión que permite al agente seleccionar dinámicamente la herramienta más pertinente para alcanzar el objetivo requerido.

Consideremos, por ejemplo, un escenario de comercio electrónico:

- El agente podría utilizar una herramienta para extraer los códigos de los productos de una reseña.

- Si fuera necesario, podría activar otra herramienta para generar un código de descuento.

- En función de la entrada del usuario, el agente decide qué herramienta invocar, sin intervención humana.

Es aquí donde la IA generativa pasa de ser un asistente a convertirse en un orquestador autónomo de los procesos empresariales. En lugar de codificar rígidamente los flujos de trabajo, KNIME permite construir sistemas flexibles y adaptables capaces de responder de forma inteligente a los cambios en las entradas y a las necesidades de los usuarios.

Gobernanza y GenAI responsable

Por supuesto, el poder conlleva responsabilidades. Aunque la IA generativa tiene un enorme potencial, también introduce nuevos riesgos: interpretabilidad limitada, resultados imprecisos, posibles sesgos, problemas de conformidad y mucho más. Por eso KNIME y Databricks dan prioridad a la gobernanza.

Databricks reduce el riesgo al poner a disposición solo modelos aprobados de forma centralizada, en lugar de depender directamente de LLM de código abierto o de terceros no verificados. Este servicio impide el uso incontrolado de los modelos por parte de los equipos.

KNIME amplía este nivel de gobernanza salvaguardando la forma en que se utilizan e integran dichos modelos:

- Evaluación de LLM y aplicaciones. KNIME se integra con Giskard para evaluar los LLM y las aplicaciones basadas en LLM en busca de riesgos como alucinaciones, sesgos o contenidos dañinos. A continuación, los equipos pueden tomar medidas como perfeccionar las indicaciones, adoptar sistemas RAG para reducir las alucinaciones o incluso reconsiderar la selección de modelos.

- Privacidad y anonimización de datos. La conformidad se respalda mediante integraciones con Microsoft Presidio para la anonimización de texto y la extensión Redfield Privacy Nodes para datos tabulares. Esto garantiza que la información confidencial se gestione de forma responsable en todos los flujos de trabajo.

- Perfiles de personalización. A nivel organizativo, KNIME Business Hub permite a los administradores restringir el acceso a proveedores o nodos no verificados e imponer el uso de conectores Databricks aprobados (por ejemplo, Databricks LLM Selector).

- Credenciales y seguridad centralizadas. El almacenamiento seguro de credenciales a través de KNIME Hub, incluidos los tipos de secretos de Databricks, garantiza que los datos confidenciales nunca salgan de un entorno controlado.

| Nivel | Funcionalidad de gobernanza | Herramientas clave/Integraciones |

| Individual |

|

|

| Organizativo |

|

|

En conjunto, estas funciones permiten aplicar una gobernanza tanto a nivel individual como organizativo, equilibrando la innovación y la gestión de riesgos. De este modo, las organizaciones pueden adoptar GenAI de forma rápida y responsable, generando confianza en el proceso de toma de decisiones basado en la inteligencia artificial.

Consideraciones finales

Con KNIME y Databricks, la IA generativa se convierte en una parte fiable y escalable del análisis y la toma de decisiones empresariales.

- Los equipos empresariales pueden experimentar e innovar con flujos de trabajo de bajo código.

- Los equipos de ciencia de datos pueden hacer uso de modelos gestionados de forma centralizada.

- Las organizaciones pueden utilizar la IA de forma segura, responsable y colaborativa.

Con esto concluye nuestra serie Databricks y KNIME: desde la inteligencia empresarial hasta la ingeniería de datos, el aprendizaje automático y, por último, la integración de GenAI. Cada blog de la serie se basa en los capítulos anteriores y muestra cómo KNIME y Databricks juntos pueden crear para las empresas un ecosistema de datos e IA integral, accesible, transparente y listo para su uso en producción.

¿Listo para empezar a experimentar? Explora el curso oficial KNIME Databricks for AI, descarga KNIME Analytics Platform y conéctate a tu espacio de trabajo Databricks hoy mismo.

¿Quieres profundizar más? Contacta con nosotros para un asesoramiento gratuito.